Pythonで統計学を学ぶ!📊データの傾向を分析

Pythonで統計学を学ぶことは、データの背後にあるストーリーを理解するための強力な方法です。📊 データ分析において、統計的手法を活用することで、複雑な情報から明確な傾向やパターンを抽出できます。Pythonはそのシンプルさと豊富なライブラリ群により、初心者から専門家まで幅広い層に支持されています。特にPandasやNumPy、Matplotlibなどのツールを使うことで、効率的にデータを処理し視覚化することが可能です。この記事では、Pythonを用いて統計学の基礎を学び、実際のデータセットを使って傾向を分析するプロセスを解説します。

Pythonで統計学を学ぶ重要性とデータ分析への応用

Pythonは、統計学を学びデータの傾向を分析するための強力なツールです。このセクションでは、その具体的な方法やメリットについて解説します。

1. Pythonにおける基本的な統計解析手法

Pythonを使用して基本的な統計解析を行うには、以下のステップが重要です。

- 平均値・中央値・最頻値を計算する関数(NumPyやPandasの活用)。

- 標準偏差や分散といったデータのばらつきを評価する指標の算出。

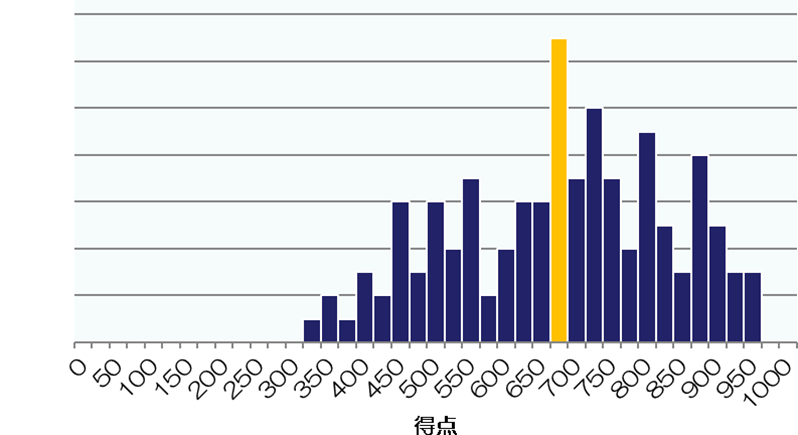

- ヒストグラムや散布図を利用してデータ分布を視覚化する方法。

2. データ可視化の役割と主なライブラリ

データ分析において、データ可視化は非常に重要な役割を果たします。以下のようなツールが利用可能です。

- Matplotlibを使って棒グラフや折れ線グラフを作成する。

- Seabornを使い、高度なヒートマップやペアプロットを描画する。

- Plotlyでインタラクティブなチャートを実装する方法。

3. 統計モデル構築の基礎

Pythonでは様々な統計モデルを簡単に構築できます。

- 回帰分析を行い、変数間の相関関係を調べる。

- SciPyモジュールを使用して、仮説検定を実施する。

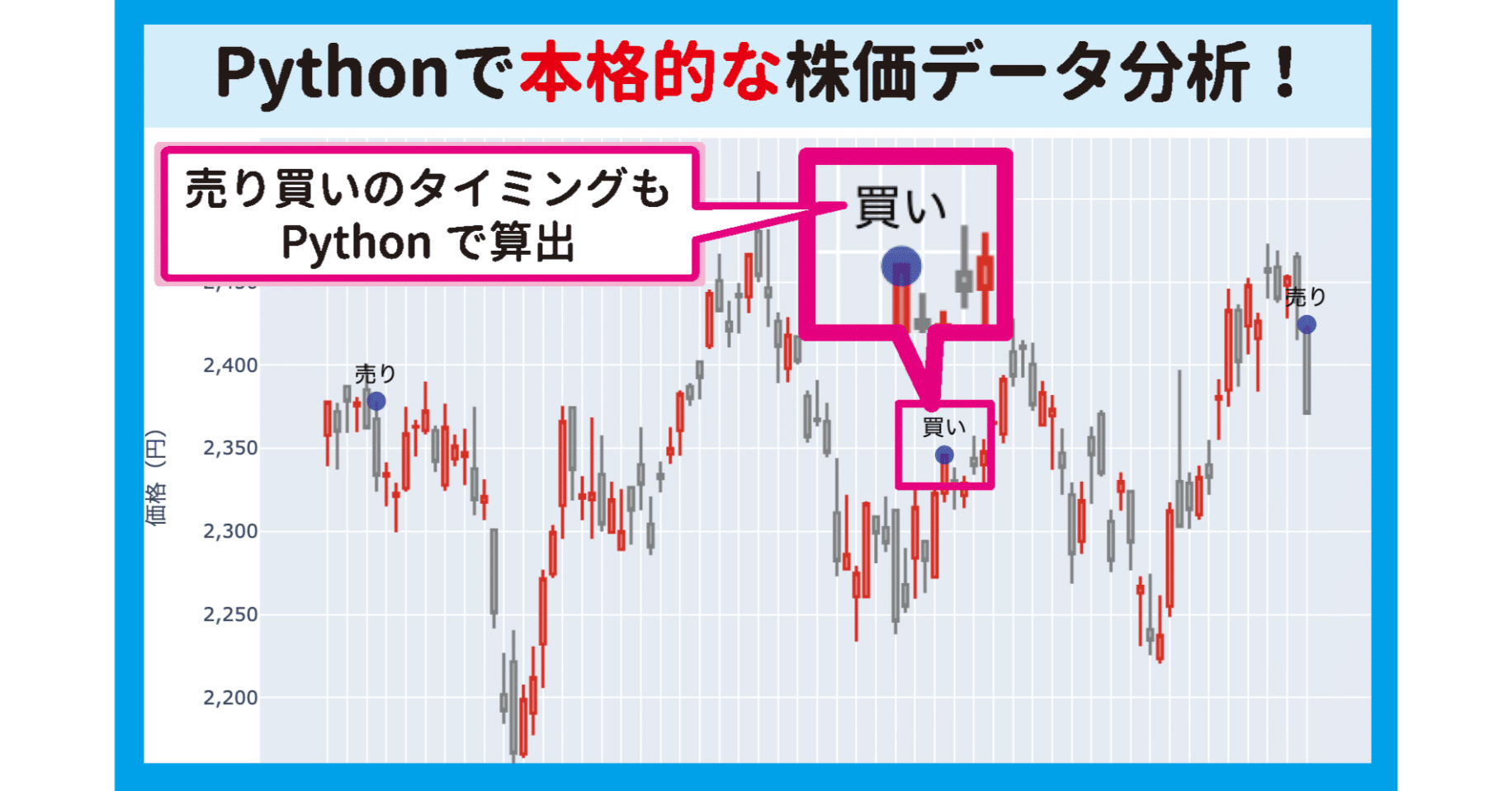

- 時系列データに対して予測モデルを適用する方法。

4. データクリーニングと前処理の重要性

分析結果の精度を向上させるために、適切なデータクリーニングが必要不可欠です。

- 欠損値を補完または削除する技術。

- 外れ値を検出し、適切に除外する方法。

- データを正規化またはスケーリングするプロセス。

5. 実践的なケーススタディとプロジェクト例

最後に、Pythonを使った実践的なプロジェクトを通して学びを深めましょう。

- 顧客データを分析し、購買傾向を特定するケース。

- アンケート結果から、回答者の共通点を抽出する例。

- Webサイトのアクセスログを元にしたユーザ行動分析。

Pythonのデータ分析の合格率は?

Pythonのデータ分析の合格率は、試験やコースの提供元によって異なります。一般的に、Pythonを用いたデータ分析に関する資格試験やコースでは、受験者のスキルレベルや準備状況、試験の難易度が大きく影響します。一部の試験では約60%から75%の合格率が報告されていますが、これはあくまで目安であり、具体的な数値は公式発表を確認する必要があります。

Pythonデータ分析試験の難易度

Pythonデータ分析の試験は、初心者向けのものから上級者向けのものまで多岐にわたります。

- 基本的な文法とライブラリ(例: Pandas, NumPy)の理解が必要です。

- 統計学や機械学習の知識が求められる高度な問題も出題されます。

- 実務経験がある受験者は合格率が高い傾向があります。

合格率に影響を与える要因

合格率にはさまざまな要因が関与しています。以下は主なポイントです。

- 学習時間の確保が不足すると、十分な準備ができない可能性があります。

- 利用可能な教材の質や講座の内容が重要です。

- 試験当日の集中力や時間配分が結果に影響します。

効果的な学習方法

効率的な学習戦略を立てることで、合格率を向上させることができます。

- 模擬試験を活用して実際の試験形式に慣れましょう。

- Pythonの実践的なプロジェクトに取り組むことで理解が深まります。

- コミュニティやフォーラムで情報を共有し、不明点を解消しましょう。

Pythonで分析するにはどうしたらいいですか?

Pythonでのデータ分析の基本ステップ

Pythonを使用してデータ分析を行うためには、以下の手順が重要です。まず、適切なライブラリをインポートし、データを読み込んで前処理を行います。

- PandasやNumpyなどの主要なライブラリをインストール・インポートすることで、効率的なデータ操作が可能になります。

- CSVやExcelファイルからデータを読み込む際は、pd.read_csv()やpd.read_excel()を使用します。

- 欠損値の処理やデータの正規化を行い、分析可能な状態に整えます。

可視化ツールの活用方法

MatplotlibやSeabornといった可視化ライブラリを使うことで、データを視覚的に理解することができます。

- 散布図やヒストグラムを利用して、データの分布を確認します。

- 複数の変数間の関係性を把握するためには、相関行列のヒートマップを作成します。

- グラフのカスタマイズにより、プレゼンテーション品質の高い結果を生成します。

機械学習モデルの適用

Pythonでは、Scikit-learnのような強力な機械学習ライブラリを使用して予測モデルを構築できます。

- データセットをトレーニングセットとテストセットに分割し、モデルの汎化性能を確保します。

- 回帰分析や分類タスクに応じて適切なアルゴリズム(例:ランダムフォレスト、SVMなど)を選択します。

- スバリデーションやグリッドサーチを活用し、モデルのパラメータを最適化します。

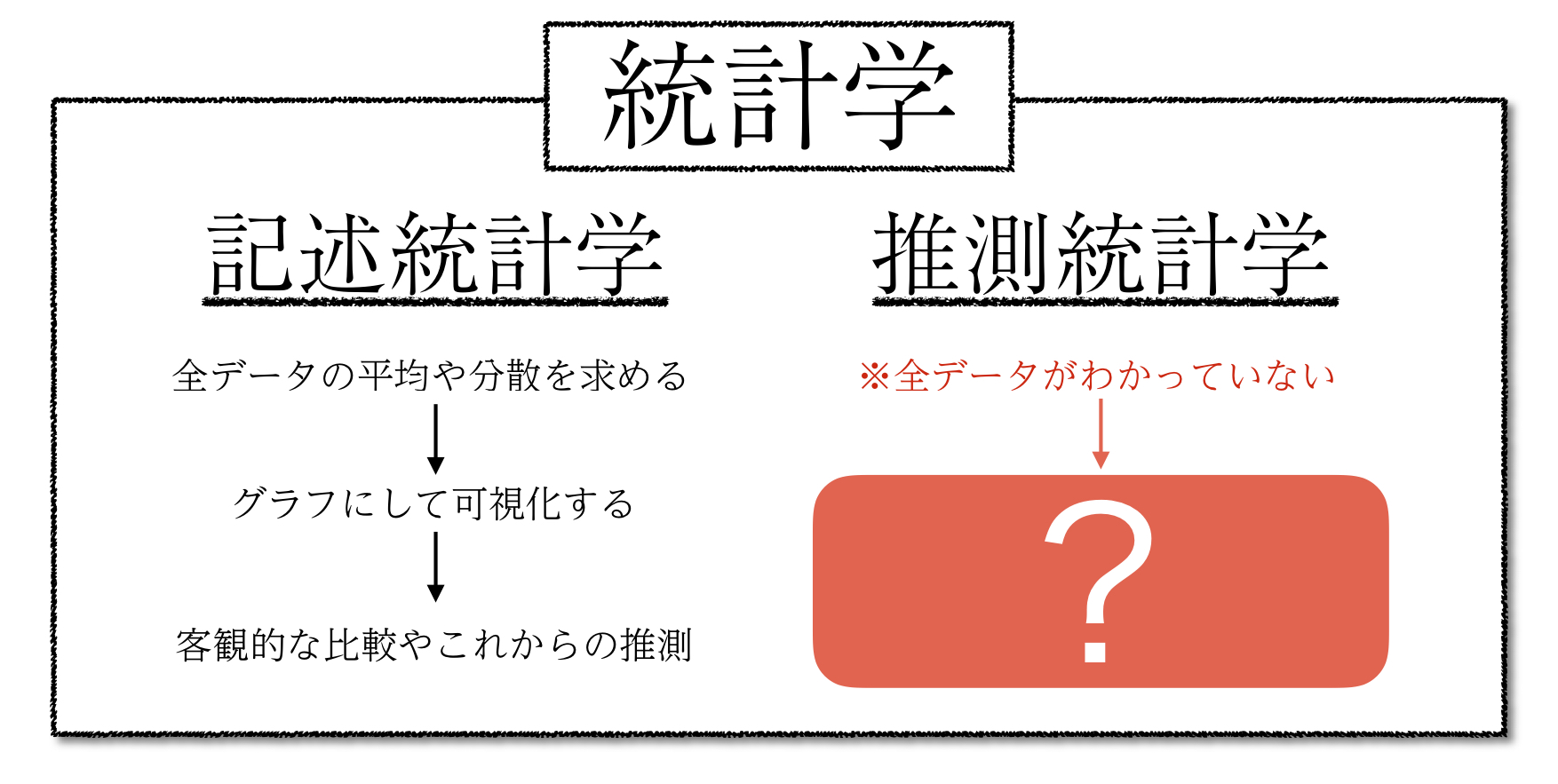

統計学とデータ分析の違いは何ですか?

統計学はデータの収集、整理、分析、解釈を通じて現象を理解し、その背後にある法則やパターンを探る学問です。一方、データ分析は具体的なデータセットから有用な情報を抽出し、意思決定に役立てる実践的なプロセスです。統計学が理論的背景を持つ学問であるのに対し、データ分析は目的志向型でビジネスや研究などに直接適用されます。

統計学の主な特徴

統計学はデータに基づいて現実を理解するための基盤となる方法論です。

- 確率モデルの使用: 統計学では確率分布を用いてデータのランダム性を評価します。

- 仮説検定: 母集団に関する仮説を立て、それが妥当かどうかを検証します。

- 推測統計: サンプルデータから全体の特性を予測・推定します。

データ分析のアプローチ

データ分析は特定の目的に応じてデータを扱い、結果を導き出すプロセスです。

- 探索的データ分析 (EDA): データの概要や傾向を視覚化し、洞察を得ます。

- 機械学習の活用: アルゴリズムを利用して予測モデルや分類モデルを構築します。

- 可視化技術: グラフやチャートを使用してデータをわかりやすく表現します。

両者の相違点と連携

統計学とデータ分析は互いに関連しながらも異なる目的を持っています。

- 目的の違い: 統計学は理論的探究が中心ですが、データ分析は問題解決に焦点を当てています。

- ツールの利用: データ分析はプログラミング言語(例: Python、R)を頻繁に利用しますが、統計学は数学的計算を重視します。

- 相互補完: 統計学的手法はデータ分析において信頼性を高める手段として不可欠です。

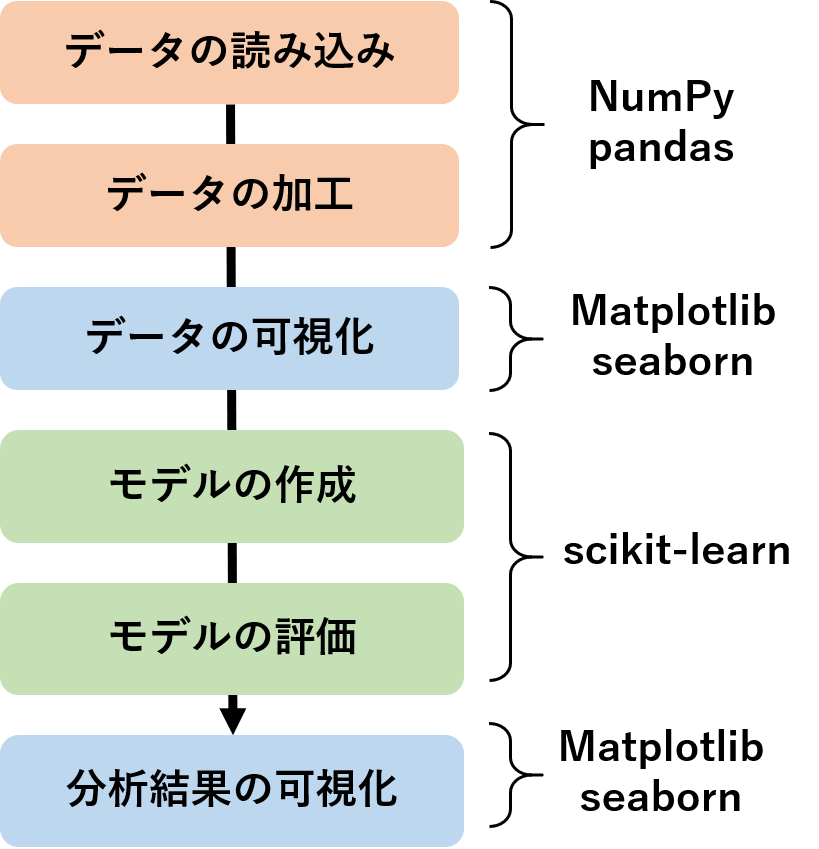

Pythonのデータ分析の流れは?

Pythonのデータ分析の流れは、一般的に以下のステップで進行します:まずデータの収集を行い、次にデータの前処理を実施し、その後データの分析や可視化を行い、最後に結果を解釈してレポートを作成します。

データの収集とは?

データの収集は、Pythonを使ったデータ分析プロセスにおける最初のステップです。この段階では、目的に応じた適切なデータソースから情報を抽出します。

- APIを利用して外部サービスからデータを取得する。

- CSVやExcelなどのファイル形式で保存されたデータを読み込む。

- データベースから直接クエリを使用してデータを取得する。

データの前処理の重要性

データの前処理は、分析を行う前にデータを整理し、クリーンアップする作業です。これにより、分析の精度が向上します。

- 欠損値を補完または削除することでデータセットを整える。

- 不要な列や行をフィルタリングしてデータを軽量化する。

- カテゴリカルデータを数値化して機械学習モデルに対応させる。

データの可視化と洞察

データの可視化は、分析結果を理解しやすくするために重要な役割を果たします。グラフやチャートを使うことでパターンを発見しやすくなります。

- MatplotlibやSeabornを使って散布図やヒストグラムを作成する。

- Pandasの機能を活用してデータの概要をサマライズする。

- インタラクティブな可視化ツール(例: Plotly)でユーザー体験を向上させる。

よくある質問

Pythonで統計学を学ぶ際に必要な前提知識は何ですか?

Pythonで統計学を学ぶためには、まずプログラミングの基礎と数学の基本概念を理解していることが重要です。特に、変数、データ型、条件分岐、ループなどの基本的なプログラミングスキルが必要です。また、統計学では平均、分散、標準偏差といった概念が頻繁に登場するため、これらに対する理解も深めておくべきです。さらに、PythonにはPandasやNumPy、Matplotlibといった強力なライブラリがありますので、これらの基本的な使い方を学ぶことで効率的にデータ分析を行う準備が整います。

Pythonでどの統計ライブラリを使うのがおすすめですか?

Pandasはデータ操作と解析に非常に便利で、表形式のデータを扱う際に特に優れています。一方で、NumPyは数値計算に特化しており、多次元配列の処理や線形代数の計算において欠かせないツールです。SciPyは高度な科学技術計算をサポートし、統計的仮説検定などにも活用できます。可視化に関しては、MatplotlibやSeabornが一般的であり、分布や相関関係を視覚的に確認するのに役立ちます。初心者の方には、まずはPandasとMatplotlibから始めるのがおすすめです。

Pythonでデータの傾向を分析する手順を教えてください。

まず、データの収集と前処理を行います。Pandasを使用してデータを読み込み、欠損値の補完や異常値の除去などを行います。次に、データの記述統計量を算出します。これには平均値、中央値、最頻値などが含まれます。その後、データの分布や相関関係を可視化するためにグラフを作成します。最後に、仮説検定や回帰分析などを実施し、データの背後にあるパターンやトレンドを解釈します。このプロセス全体を通じて、データに基づく意思決定をサポートする知見を得ることが可能です。

Pythonで統計学を学ぶメリットは何ですか?

Pythonは学習コストが比較的低く、初心者にも取り組みやすい言語であるため、統計学を学ぶ際の障壁を下げることができます。また、豊富なライブラリが提供されているため、データの読み込みから解析、可視化までを一貫して行えます。さらに、Pythonは他の分野(例:機械学習、ウェブ開発)にも応用できるため、将来的にキャリアの幅を広げる可能性もあります。統計解析の理論を学びながら同時に実践的なスキルを身につけることができる点が、Pythonで統計学を学ぶ最大のメリットと言えるでしょう。